当社の最新製品については、新製品ページをご覧ください。

【完全版】Googleにインデックス登録されない14個の原因と解決策 - 2025年版

更新日:2025年12月15日

監修者

株式会社メディアリーチ 代表取締役 松村 俊樹

兵庫県神戸市生まれ。2012年立命館大学卒業後、株式会社インテリジェンス(現パーソルキャリア)で採用支援に従事。2015年、米国デジタルエージェンシーPierry(現Wunderman Thompson)に入社し、日本支社立ち上げ、MAやSEOコンサルティングに従事。その後、富士フイルムグループ会社でグローバルデータベース型SEOに従事、2021年に株式会社メディアリーチを設立し、代表取締役に就任。日本国内企業や北米、欧州、中国本社のグローバル企業のSEO支援も行う。SEO経歴10年以上。デジマナMEETにLLMO関連で講師登壇 / 東京都中小企業振興公社運営のTOKYO創業ステーションイベントにLLMO関連で登壇

「Googleの検索結果に自社のWebサイトが表示されない」

この悩みを抱える方は少なくありません。

本記事では、2025年現在のGoogleにインデックス登録されない理由とその解決策、インデックス登録の確認方法、そして登録を促進するためのベストプラクティスについて詳しく解説します。

SEO対策の基本となるインデックス登録の重要性を理解し、効果的な対策を講じることで、あなたのサイトの可視性を大幅に向上させることができるでしょう。

■■メディアリーチのSEO対策サービスのご案内■■

当社は東京・大阪を拠点に置くSEO対策コンサルティングに強い会社です。

「検索順位が上がらない」「流入が下がった」「被リンク獲得を強化したい」という企業様はぜひ当社へご相談ください!

- Googleにインデックス登録されない14個の原因と解決策

- GoogleがURLを発見できていないため

- Googleがクロールをしていない

- 重複コンテンツが発生している

- コンテンツが低品質である

- noindexタグが設定されている

- robots.txtでクロール拒否をしている

- Googleのペナルティを受けている

- Webサーバーエラーが起きている

- 被リンクが少ない

- ページ読み込みの速度が遅い

- URL削除リクエストを過去にした

- サイトが大規模である

- 頻繁にページ追加、削除をしている

- Googleにインデックスされている確認する方法

- Googleコマンド「「site:URL」で検索」※必ず正しいわけではない

- Googleサーチコンソールで確認する

- Googleにインデックス登録されるまでの期間・Googleに反映されるまで

- Googleにインデックス登録させる基本・ベストプラクティス

- XMLサイトマップを作成・送信する

- 内部リンクを設置する

- SNS運用を行う

- Googleサーチコンソール「URL検査ツール」で、インデックス登録リクエストを行う

- Googleサーチコンソールの「ページがインデックスに登録されなかった理由」の各エラー解説

- クロール済み - インデックス未登録

- 検出 - インデックス未登録

- noindex タグによって除外されました

- 重複しています。Google により、ユーザーがマークしたページとは異なるページが正規ページとして選択されました

- サーバーエラー(5xx)

- アクセス禁止(403)が原因でブロックされました

- robots.txt によりブロックされました

- インデックスに登録されていないページ数の確認方法

- Googleにインデックス登録されているのに表示されないケース

Googleにインデックス登録されない14個の原因と解決策

Googleの検索結果に自社のウェブページが表示されない原因は多岐にわたります。ここでは、主な理由とその解決策について詳しく解説していきます。インデックス登録の問題を特定し、適切な対策を講じることで、サイトの検索エンジンでの可視性を向上させることができます。

GoogleがURLを発見できていないため

ウェブサイトがGoogleのインデックスに登録されない最も基本的な理由の一つは、GoogleがそのURLを発見できていないことです。これは、新しいウェブサイトや、内部リンク構造が適切に設計されていないサイトでよく見られる問題です。

Googleの検索エンジンは、ウェブをクロールし、新しいページを発見するために既知のURLからリンクをたどります。そのため、あなたのウェブページが他のページから適切にリンクされていない場合、Googleはそのページの存在を認識できない可能性があります。

この問題を解決するためには、以下の対策が効果的です:

サイトマップの作成と送信:XMLサイトマップを作成し、Googleサーチコンソールを通じてGoogleに送信することで、サイト内の全ページのURLをGoogleに知らせることができます。

内部リンク構造の最適化:ホームページから全てのページにアクセスできるよう、適切な内部リンク構造を設計します。これにより、Googleのクローラーがサイト内の全ページを発見しやすくなります。

参考:内部リンクの貼り方・貼る場所を解説!SEO効果の高い内部リンクの最適化方法外部リンクの獲得:他の信頼性の高いウェブサイトからリンクを獲得することで、Googleがあなたのサイトを発見する可能性が高まります。

これらの対策を実施することで、GoogleがあなたのウェブページのURLを発見し、インデックスに登録する可能性が大幅に向上します。

Googleがクロールをしていない

GoogleがURLを発見できても、実際にそのページをクロールしていない可能性があります。クロールとは、Googleのボットがウェブページの内容を読み取り、インデックスに登録するためのプロセスです。

クロールが行われない主な理由には以下のようなものがあります:

クロール予算の制限:Googleは各サイトに対して「クロール予算」を設定しており、大規模なサイトではすべてのページをクロールしきれない場合があります。

サーバーの応答速度:サーバーの応答が遅い場合、Googleはクロールを中断する可能性があります。

robots.txtによるブロック:誤って設定されたrobots.txtファイルがGoogleのクローラーをブロックしている可能性があります。

これらの問題を解決するためには、以下の対策が効果的です:

サイト構造の最適化:重要なページへのリンクを増やし、クロール優先度を明確にします。

サーバーのパフォーマンス改善:ページ読み込み速度を向上させ、サーバーの応答性を改善します。

robots.txtの適切な設定:robots.txtファイルを確認し、不要なブロックを解除します。

Googleサーチコンソールの活用:「URL検査」ツールを使用して、特定のURLのクロール状況を確認し、必要に応じてクロールをリクエストします。

これらの対策により、Googleがより効率的にあなたのサイトをクロールし、インデックスに登録する可能性が高まります。

重複コンテンツが発生している

重複コンテンツの存在は、Googleのインデックス登録を妨げる重大な要因の一つです。同一または非常に類似したコンテンツが複数のURLで提供されている場合、Googleはどのバージョンをインデックスに登録すべきか判断に迷い、結果として全てのバージョンをインデックスから除外してしまう可能性があります。

重複コンテンツが発生する主な原因には以下のようなものがあります:

URLパラメータの問題:商品のソート順やフィルタリングによって生成される異なるURLが、同じコンテンツを表示している。

WWWとWWWなしのバージョン:www.example.comとexample.comが同じコンテンツを表示している。

HTTPとHTTPSのバージョン:セキュアでないHTTPとセキュアなHTTPSの両方でアクセス可能になっている。

プリントページや携帯用ページ:同じコンテンツの異なるバージョンが別URLで提供されている。

この問題を解決するためには、以下の対策が効果的です:

正規化(Canonicalization):重複しているページに対して、canonical タグを使用して正規URLを指定します。

リダイレクトの適切な設定:WWWとWWWなし、HTTPとHTTPSの間で301リダイレクトを設定し、一つのバージョンに統一します。

URLパラメータの管理:GoogleサーチコンソールでURLパラメータを適切に設定し、不要なパラメータによる重複を防ぎます。

サイトマップの最適化:正規URLのみをサイトマップに含めることで、Googleに正しいURLを示唆します。

これらの対策を実施することで、重複コンテンツの問題を解消し、Googleが適切にインデックス登録を行える環境を整えることができます。結果として、サイトの検索パフォーマンスが向上し、SEO効果の最大化につながります。

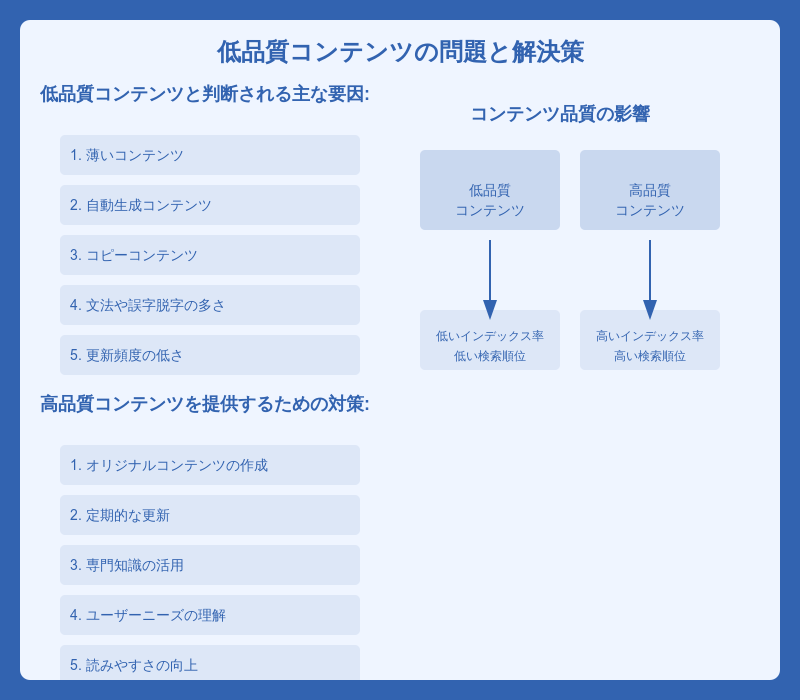

コンテンツが低品質である

Googleはユーザーに高品質な検索結果を提供することを最優先としています。そのため、コンテンツの質が低いと判断されたページは、インデックスに登録されない、あるいは登録されても検索結果で低い順位に表示されてしまう可能性があります。

低品質コンテンツと判断される主な要因には以下のようなものがあります:

薄いコンテンツ:情報量が少なく、ユーザーにとって価値が低い。

自動生成コンテンツ:AIによる大量生成など、人間の編集を経ていない。

コピーコンテンツ:他のサイトからの無断転載や、わずかな変更を加えただけの内容。

文法や誤字脱字の多さ:プロフェッショナルさに欠ける印象を与える。

更新頻度の低さ:長期間更新されていないコンテンツは、最新の情報を反映していない可能性がある。

この問題を解決し、高品質なコンテンツを提供するためには、以下の対策が効果的です:

オリジナルコンテンツの作成:ユーザーにとって価値のある、独自の視点や情報を盛り込んだコンテンツを作成します。

定期的な更新:既存のコンテンツを定期的に見直し、最新の情報や事例を追加します。

専門知識の活用:業界の専門家や経験者の知見を取り入れ、深い洞察を提供します。

ユーザーニーズの理解:検索意図を分析し、ユーザーが求める情報を的確に提供します。

読みやすさの向上:適切な見出し構造、段落分け、画像の使用などで、コンテンツの可読性を高めます。

文法と表現のチェック:プロフェッショナルな校正を行い、誤字脱字や文法ミスを排除します。

これらの対策を実施することで、Googleはあなたのコンテンツを高品質と判断し、インデックスに登録する可能性が高まります。結果として、検索結果での順位向上や、ユーザーエンゲージメントの改善につながり、長期的なSEO効果が期待できます。

noindexタグが設定されている

noindexタグは、特定のページをGoogleのインデックスから除外するよう指示するためのHTMLタグです。このタグが誤って設定されていると、重要なページがインデックスに登録されない原因となります。

noindexタグが不適切に設定される主な理由には以下のようなものがあります:

開発段階の設定忘れ:サイト構築時に一時的に設定したnoindexタグを、公開後に解除し忘れる。

プラグインやテーマの設定ミス:CMSのプラグインやテーマの設定で、意図せずnoindexタグが追加される。

robots.txtとの混同:robots.txtファイルでのクロール制御と混同し、誤ってnoindexタグを使用する。

サイト全体への適用:サイト全体のテンプレートにnoindexタグを誤って追加してしまう。

この問題を解決するためには、以下の対策が効果的です:

サイト全体のチェック:全ページのソースコードを確認し、不要なnoindexタグを特定します。

メタロボットタグの適切な設定:インデックスに登録したいページでは、

を設定します。HTTPレスポンスヘッダーの確認:

X-Robots-Tag: noindexが誤って設定されていないか確認します。CMSの設定見直し:WordPressなどのCMSを使用している場合、「検索エンジンがサイトをインデックスしないようにする」のようなオプションがオンになっていないか確認します。

Googleサーチコンソールの活用:「カバレッジ」レポートを確認し、noindexタグによってインデックスから除外されているページを特定します。

これらの対策を実施することで、重要なページが適切にインデックスに登録されるようになり、サイトの検索可視性が向上します。ただし、プライバシーポリシーページや管理画面など、意図的にインデックスから除外したいページには引き続きnoindexタグを使用することが重要です。

robots.txtでクロール拒否をしている

robots.txtファイルは、検索エンジンのクローラーに対してサイトのどの部分をクロールしてよいか、あるいはクロールしてはいけないかを指示するためのテキストファイルです。このファイルの設定ミスにより、重要なページやサイト全体がクロールされず、結果としてインデックスに登録されない事態が発生することがあります。

robots.txtによるクロール拒否が発生する主な理由には以下のようなものがあります:

開発環境の設定が本番環境に反映:テスト段階で設定したクロール拒否が、誤って本番環境にも適用されてしまう。

過度に制限的な設定:セキュリティ上の懸念から、必要以上に多くのディレクトリやファイルをクロール拒否している。

ワイルドカードの誤用:

Disallow: /*のような過剰に広範囲な設定を行っている。User-agentの誤認識:特定のボットを制限しようとして、誤ってGooglebotも制限してしまう。

この問題を解決するためには、以下の対策が効果的です:

robots.txtの再確認:現在のrobots.txtファイルの内容を確認し、不要な制限を特定します。

適切なディレクティブの使用:

User-agent: * Allow: / Disallow: /admin/ Disallow: /private/のように、必要最小限の制限のみを設定します。Googlebotの明示的な許可:

User-agent: Googlebot Allow: /のように、Googlebotに対して明示的にクロールを許可します。サイトマップの指定:robots.txtファイル内でサイトマップのURLを指定し、クロールすべき重要なページを示唆します。

Googleサーチコンソールの活用:「robots.txtテスター」ツールを使用して、設定の影響を事前に確認します。

定期的な見直し:サイトの構造変更や新しいセクションの追加時には、robots.txtの設定の適切性を再確認します。

これらの対策を実施することで、Googleのクローラーが適切にサイトをクロールできるようになり、重要なページが確実にインデックスに登録されるようになります。ただし、管理画面やユーザー個人情報を含むページなど、クロールされたくない領域に対しては引き続き適切な制限を設けることが重要です。

Googleのペナルティを受けている

Googleのウェブマスターガイドラインに違反する行為を行った場合、サイトにペナルティが科される可能性があります。ペナルティを受けると、サイトの一部または全体がインデックスから除外されたり、検索順位が大幅に低下したりする可能性があります。

Googleペナルティの主な原因には以下のようなものがあります:

低品質なコンテンツ:薄いコンテンツ、自動生成コンテンツ、重複コンテンツなど。

不自然なリンク構築:リンクファーム、ペイドリンク、過剰な相互リンクなど。

クローキング:ユーザーとGooglebotに異なるコンテンツを表示する行為。

隠しテキストやリンク:背景色と同じ色のテキストを使用するなど。

ドアウェイページ:検索エンジン向けに最適化された低品質なランディングページ。

ペナルティからの回復には時間と労力がかかりますが、以下の対策が効果的です:

Googleサーチコンソールの確認:手動対応措置の有無を確認し、具体的な問題点を把握します。

問題の特定と修正:ガイドライン違反の原因を特定し、速やかに修正します。例えば、低品質コンテンツの改善や不自然なリンクの削除などを行います。

リカバリーリクエストの提出:問題を修正後、Googleサーチコンソールを通じてリカバリーリクエストを提出します。

継続的な品質向上:ユーザー重視の高品質なコンテンツ作成と、自然なリンク獲得に注力します。

定期的な監査:サイトの健全性を保つため、定期的にSEO監査を実施します。

ペナルティからの回復には時間がかかる場合がありますが、ガイドラインに沿った誠実な対応を続けることで、最終的にはサイトの評価を回復させることができます。

Webサーバーエラーが起きている

Webサーバーエラーは、Googleのクローラーがサイトにアクセスしようとした際に発生する技術的な問題です。これらのエラーが頻繁に発生すると、Googleはサイトを適切にクロールおよびインデックス化できなくなる可能性があります。

主なWebサーバーエラーには以下のようなものがあります:

500 Internal Server Error:サーバー側の一般的なエラー。

503 Service Unavailable:サーバーが一時的にリクエストを処理できない状態。

504 Gateway Timeout:サーバーがタイムリーに応答できない。

403 Forbidden:アクセス権限がない。

404 Not Found:リクエストされたページが見つからない。

これらの問題を解決するためには、以下の対策が効果的です:

サーバーログの分析:エラーの原因を特定するため、詳細なサーバーログを分析します。

サーバーリソースの最適化:CPU、メモリ、ディスク容量などのリソースを適切に管理し、オーバーロードを防ぎます。

CDNの活用:コンテンツデリバリーネットワーク(CDN)を使用して、サーバーの負荷を分散します。

セキュリティ設定の見直し:不要に厳しいファイアウォール設定やIPブロックがないか確認します。

404エラーの適切な処理:存在しないページに対して適切な404ページを表示し、関連コンテンツへのリンクを提供します。

リダイレクトの適切な設定:古いURLから新しいURLへの301リダイレクトを適切に設定します。

Googleサーチコンソールの活用:「カバレッジ」レポートでサーバーエラーを監視し、迅速に対応します。

これらの対策を実施することで、Webサーバーの安定性が向上し、Googleのクローラーが円滑にサイトをクロールできるようになります。結果として、インデックス登録の問題が解消され、検索エンジンでの可視性が向上します。

被リンクが少ない

被リンク(バックリンク)の数と質は、Googleがサイトの重要性や信頼性を判断する上で重要な要素の一つです。被リンクが少ないサイトは、Googleにとって重要性が低いと判断される可能性があり、結果としてインデックス登録が遅れたり、検索順位が低くなったりする可能性があります。

被リンクが少ない主な理由には以下のようなものがあります:

新しいサイト:立ち上げて間もないサイトは、自然と被リンクが少ない傾向にあります。

コンテンツの魅力不足:他のサイトからリンクされるような価値あるコンテンツが少ない。

プロモーション不足:コンテンツの存在を適切に周知できていない。

業界特性:一部の専門性の高い業界では、全般的に被リンクが少ない傾向がある。

高品質なコンテンツの作成:他のサイトが自然にリンクしたくなるような、価値のあるコンテンツを作成します。例えば、詳細な調査レポート、独自のデータ分析、有用なインフォグラフィックなどが効果的です。

被リンクアウトリーチ活動:業界の影響力のある人物やメディアとの関係構築を行い、コンテンツの紹介を依頼します。

ゲスト投稿:他の関連サイトにゲスト記事を寄稿し、自然な文脈で自社サイトへのリンクを含めます。

ソーシャルメディアの活用:TwitterやLinkedInなどのプラットフォームでコンテンツを積極的に共有し、露出を増やします。

リンク切れの営業:競合他社の壊れたリンクを見つけ、自社の関連コンテンツで代替を提案します。

リソースページの作成:業界の有用なリソースをまとめたページを作成し、他のサイトからリンクされやすくします。

イベント参加やスポンサーシップ:業界イベントに参加したり、スポンサーになったりすることで、イベントサイトからの被リンクを獲得します。

これらの戦略を組み合わせて実施することで、時間をかけて自然な被リンクを増やすことができます。ただし、被リンク獲得の際には、Googleのガイドラインに違反するような人為的なリンク構築(リンクの購入など)は避け、あくまで自然で価値のあるリンクを目指すことが重要です。

関連サービス:メディアリーチの被リンク獲得代行サービス

ページ読み込みの速度が遅い

ページの読み込み速度は、ユーザーエクスペリエンスに直接影響を与えるだけでなく、Googleのランキング要因の一つとしても重要です。ページ読み込みが遅いサイトは、クロールの効率が低下し、インデックス登録が遅れる可能性があります。また、モバイルファーストインデックスの時代において、特にモバイルでの読み込み速度は重要性を増しています。

ページ読み込みが遅くなる主な原因には以下のようなものがあります:

大きなファイルサイズの画像や動画

最適化されていないJavaScriptやCSSファイル

レンダリングをブロックするリソース

サーバーの応答時間が遅い

過剰なHTTPリクエスト

ページ読み込み速度を改善するためには、以下の対策が効果的です:

画像の最適化: 適切なフォーマットの使用(JPEG、PNG、WebPなど) 画像の圧縮 レスポンシブ画像の使用

ファイルの最小化とコンバイン: JavaScriptとCSSファイルの圧縮 複数のファイルを一つにまとめる

ブラウザキャッシュの活用: 適切なキャッシュヘッダーの設定

CDN(コンテンツデリバリーネットワーク)の利用: 静的コンテンツをCDNで配信し、ロード時間を短縮

遅延読み込みの実装: 画像やビデオの遅延読み込み 必要なJavaScriptのみを初期ロード時に読み込む

サーバーの最適化: データベースクエリの最適化 サーバーサイドキャッシュの実装 適切なホスティングプランの選択

AMPの導入: モバイルページの高速化のためのAccelerated Mobile Pages(AMP)の実装

プリフェッチとプリロードの活用: 重要なリソースを事前に読み込む

ページ速度の改善状況を確認するには、以下のツールが役立ちます:

Google PageSpeed Insights

Googleサーチコンソールの「コアウェブバイタル」レポート

GTmetrix

WebPageTest

これらの最適化を行うことで、ページ読み込み速度が向上し、ユーザーエクスペリエンスの改善とともに、Googleのクロールとインデックス登録の効率化にもつながります。結果として、検索順位の向上や、サイトのコンバージョン率の改善も期待できます。

URL削除リクエストを過去にした

過去にGoogleサーチコンソールを通じてURL削除リクエストを行った場合、そのURLは一定期間Googleの検索結果から除外されます。この機能は主に、緊急に検索結果から削除する必要があるページ(個人情報の漏洩など)に対して使用されますが、誤って使用した場合や、削除の必要がなくなった場合に問題となることがあります。

URL削除リクエストに関する主な問題点:

永続的な削除ではない:URL削除リクエストの効果は通常約6ヶ月間続きますが、その後自動的に解除されます。

インデックスからの完全な削除ではない:URLは検索結果に表示されなくなりますが、完全にGoogleのインデックスから削除されるわけではありません。

意図しない範囲の削除:ワイルドカードを使用した削除リクエストで、必要以上に多くのURLが影響を受ける可能性があります。

この問題を解決し、削除したURLを再度インデックスに登録するためには、以下の対策が効果的です:

削除リクエストの確認: Googleサーチコンソールの「URL削除」ツールで、過去に行った削除リクエストを確認します。

削除リクエストの取り消し: まだ有効期限内の削除リクエストがある場合は、それを取り消します。

インデックス登録のリクエスト: 「URL検査」ツールを使用して、該当のURLをGoogleに再クロールとインデックス登録をリクエストします。

サイトマップの更新: 削除したURLを含む最新のサイトマップをGoogleサーチコンソールに送信します。

内部リンクの確認: サイト内の他のページから、再インデックスしたいページへの内部リンクが適切に設定されているか確認します。

コンテンツの再評価: 削除リクエストを行った理由を再確認し、必要に応じてコンテンツを更新または改善します。

robots.txtとnoindexタグの確認: 該当のURLがrobots.txtでブロックされていないか、またはnoindexタグが設定されていないか確認します。

定期的なモニタリング: Googleサーチコンソールの「カバレッジ」レポートを定期的にチェックし、インデックスの状態を監視します。

これらの対策を実施することで、過去に削除リクエストを行ったURLを再度Googleのインデックスに登録し、検索結果に表示されるようになる可能性が高まります。ただし、Googleのクロールとインデックス登録のプロセスには時間がかかるため、即座に結果が反映されるわけではありません。耐えずサイトの状態を監視し、必要に応じて追加の対策を講じることが重要です。

サイトが大規模である

大規模なウェブサイトでは、ページ数が多いために全てのページをGoogleがクロールしインデックスに登録するのに時間がかかる場合があります。これは「クロール予算」と呼ばれる概念に関連しており、Googleは各サイトに対して一定のリソースしか割り当てないため、大規模サイトではすべてのページを頻繁にクロールすることが難しくなります。

参考:大規模なサイト所有者向けのクロール バジェット管理ガイド

大規模サイトでインデックス登録の問題が発生する主な理由:

クロール予算の制限:Googleが割り当てるクロール予算を超えてしまう。

サイト構造の複雑さ:深い階層構造や複雑な内部リンクにより、重要ページへのクロールが遅れる。

重複コンテンツの多さ:似たようなページが多数存在し、個々のページの重要性が低下する。

サーバーリソースの制限:大量のクロールリクエストによりサーバーの負荷が高まる。

これらの問題を解決し、大規模サイトのインデックス登録を最適化するためには、以下の対策が効果的です:

サイト構造の最適化: フラットな階層構造を目指し、重要なページへのクリック数を最小限に抑える。 明確なカテゴリ分けとナビゲーション設計を行う。

内部リンクの戦略的配置: 重要なページへの内部リンクを増やし、PageRankの流れを最適化する。 サイトのフッターやサイドバーに重要ページへのリンクを配置する。

XML サイトマップの最適化: 重要度に応じてページを分類し、複数のサイトマップを作成する。 変更頻度や優先度を適切に設定する。 大規模サイトの場合、サイトマップインデックスを活用する。

プライオリティページの特定と最適化: コアとなる重要ページを特定し、それらのページの品質と更新頻度を高める。 Googleサーチコンソールの「URL検査」ツールを使用して、重要ページの優先的なクロールをリクエストする。

重複コンテンツの管理: canonical タグを適切に使用し、類似ページの正規URLを指定する。 パラメータ付きURLの管理をGoogleサーチコンソールで適切に設定する。

ページングの最適化: rel="next" と rel="prev" を使用して、ページング関係を明確にする。 無限スクロールの場合は、適切なページング構造も並行して提供する。

JavaScript レンダリングの最適化: クリティカルコンテンツは初期HTML内に配置する。 動的コンテンツの適切なプリレンダリングを行う。

クローリングとレンダリングの効率化: CSS と JavaScript ファイルの最小化と結合を行う。 画像の最適化とレスポンシブ画像の使用。

サーバーリソースの最適化: CDNの活用によるサーバー負荷の分散。 キャッシュ戦略の適切な実装。

Google Search Console の積極的な活用: 「インデックス カバレッジ」レポートを定期的にチェックし、インデックスの問題を早期に発見する。 「クロール統計」レポートでクロールの頻度と量を監視し、必要に応じて調整を行う。

これらの対策を総合的に実施することで、大規模サイトであってもGoogleのクロールとインデックス登録を効率化し、重要なページが適切にインデックスされる可能性を高めることができます。ただし、サイトの規模や複雑さによっては、全てのページをインデックスに登録することは現実的ではない場合もあります。そのため、ビジネス目標に照らして最も重要なページに注力し、それらのページのインデックス登録と検索順位の向上を優先することが重要です。

頻繁にページ追加、削除をしている

ウェブサイトで頻繁にページの追加や削除を行うことは、Googleのクロールとインデックス登録プロセスに影響を与える可能性があります。特に大規模なeコマースサイトや、日々多くの記事を公開・削除するニュースサイトなどで、この問題が顕著に現れることがあります。

頻繁なページの追加・削除が引き起こす主な問題:

クロール効率の低下:Googleのクローラーが新しいページと削除されたページを把握するのに時間がかかる。

インデックスの不整合:実際のサイト状況とGoogleのインデックスにズレが生じる。

検索結果の品質低下:削除されたページが検索結果に表示され続ける、または新しいページが反映されない。

クロール予算の浪費:不要なページのクロールに資源が使われ、重要なページのクロールが遅れる。

これらの問題を緩和し、頻繁な更新にもかかわらず適切なインデックス登録を維持するためには、以下の対策が効果的です:

動的サイトマップの実装: ページの追加・削除に応じて自動的に更新されるサイトマップを実装する。 最終更新日時を正確に反映させる。

HTTP ステータスコードの適切な使用: 削除されたページには 404 (Not Found) または 410 (Gone) を返す。 一時的に利用できないページには 503 (Service Unavailable) を使用する。

リダイレクトの適切な管理: 削除されたページの代替ページがある場合は、301 (Permanent Redirect) を設定する。 リダイレクトチェーンを最小限に抑える。

Google Search Console の積極的な利用: 「URL 検査」ツールで新しいページのインデックス登録をリクエストする。 「削除リクエスト」ツールで不要になったページを一時的に検索結果から除外する。

優先順位付けとタグ付け: 重要度の高いページには

のようなタグを付ける。 これにより、クローラーに優先的にクロールすべきページを示唆できる。If-Modified-Since ヘッダーの活用: サーバー側で適切に実装し、変更のないページの不要なクロールを減らす。

有効期限の設定: 期間限定のページには、適切な有効期限を meta タグで指定する。 htmlCopy

クローリング頻度の最適化: Google Search Console の「クロール頻度」設定を調整し、サイトの更新頻度に合わせる。

ページのプレロードとキャッシュ戦略: 頻繁に更新されるページのプレロードを実装し、ユーザーとクローラーの両方にとってアクセスを高速化する。

コンテンツの一時的な非表示: 季節限定商品などの場合、ページを完全に削除せずに、一時的に非表示にする戦略を検討する。

インクリメンタルインデックシング: 大規模な更新がある場合、一度にすべてを変更するのではなく、段階的に更新を行う。

これらの戦略を組み合わせることで、頻繁なページの追加・削除がある場合でも、Googleのクロールとインデックス登録プロセスを最適化し、検索結果の品質を維持することができます。

ただし、サイトの特性や更新頻度によって最適なアプローチは異なるため、継続的なモニタリングと調整が必要です。Google Search Console の各種レポートを定期的にチェックし、インデックスの状況や検索パフォーマンスを注視しながら、必要に応じて戦略を微調整していくことが重要です。

Googleにインデックスされている確認する方法

Googleにウェブページがインデックスされているかどうかを確認することは、SEO戦略の重要な一部です。ここでは、インデックス状況を確認する2つの主要な方法について詳しく説明します。

Googleコマンド「「site:URL」で検索」※必ず正しいわけではない

Googleの検索結果でサイトのインデックス状況を簡単に確認する方法として、「site:」コマンドがあります。このメソッドは迅速で簡単ですが、100%正確ではないことに注意が必要です。

使用方法:

Googleの検索ボックスに「site:あなたのドメイン」と入力します。例:site:example.com

検索結果に表示されるページが、Googleにインデックスされているページです。

この方法の特徴:

簡便性: 特別なツールやアカウントが不要で、誰でも即座に利用可能。 サイト全体のおおよそのインデックス状況を素早く把握できる。

詳細検索: 「site:example.com/category/」のように、特定のディレクトリやサブドメインに絞った検索も可能。 「site:example.com filetype:pdf」のように、特定のファイルタイプに限定した検索もできる。

キーワード組み合わせ: 「site:example.com キーワード」として、サイト内の特定キーワードを含むページを検索できる。

注意点:

結果の正確性: 表示される結果数は概算値であり、実際のインデックス数と異なる場合がある。 最新の変更が反映されるまでに時間がかかることがある。

完全性の欠如: インデックスされているが検索結果に表示されていないページが存在する可能性がある。

一時的な変動: Google検索結果の一時的な変動により、結果が日によって異なる場合がある。

このメソッドは、サイトのインデックス状況の概要を素早く把握するのに適していますが、詳細や正確な情報が必要な場合は、次に説明するGoogleサーチコンソールの使用をお勧めします。

Googleサーチコンソールで確認する

Googleサーチコンソールは、ウェブサイトのインデックス状況を正確に確認できる公式ツールです。サイト所有者やWebマスターに詳細な情報を提供し、SEO改善に役立つ様々な機能を備えています。

使用方法:

Googleサーチコンソールにサインインし、対象のサイトを選択。

左側のメニューから「インデックス」→「カバレッジ」を選択。

Googleサーチコンソールの特徴:

正確性: Googleが保持する最新のインデックス情報を直接提供。 サイト:コマンドよりも正確で信頼性の高い情報が得られる。

詳細な分析: インデックスされたページ数、インデックスされていないページ数、それらの理由を詳細に表示。 エラーページや除外されたページのリストも確認可能。

時系列データ: インデックスの状況変化を時間軸で確認できる。 特定の施策の効果や問題の発生時期を特定しやすい。

URL検査ツール: 個別のURLのインデックス状況を詳細に確認できる。 クロールやインデックス登録の問題を診断し、再クロールをリクエストすることも可能。

サイトマップ管理: サイトマップを送信し、そのインデックス状況を確認できる。 サイトマップに含まれるURLと実際にインデックスされたURLの差異を把握できる。

モバイルフレンドリーテスト: モバイル版サイトのインデックス状況や問題点を確認できる。

Core Web Vitals: ページのパフォーマンスに関する重要指標を確認でき、インデックスや検索順位に影響を与える可能性のある問題を特定できる。

注意点:

初期設定の必要性: サイトの所有権を証明する必要があるため、初期設定に時間がかかる場合がある。

データの更新頻度: リアルタイムではなく、定期的に更新されるデータであるため、最新の変更がすぐには反映されない場合が

学習曲線: 多機能なツールのため、効果的な活用には多少の学習が必要。

Googleサーチコンソールは、サイトのインデックス状況を正確に把握し、SEOの問題を特定・解決するための強力なツールです。「site:」コマンドによる検索と組み合わせることで、より包括的なインデックス状況の分析が可能になります。

Googleにインデックス登録されるまでの期間・Googleに反映されるまで

Googleにウェブページがインデックス登録され、検索結果に反映されるまでの期間は、様々な要因によって大きく異なります。一般的な目安と、影響を与える主な要因について詳しく説明します。

一般的な目安:

新しいページ: 数日〜数週間

既存サイトの新規ページ: 数時間〜数日

サイト全体の大規模な変更: 数週間〜数ヶ月

インデックス登録と検索結果への反映に影響を与える主な要因:

サイトの信頼性と評価: 長期運用されている高評価のサイトは、新しいページがより速くインデックスされる傾向がある。 新規サイトは、信頼性の構築に時間がかかるため、インデックスに時間を要する場合が多い。

クロール頻度: 頻繁に更新されるサイトは、Googleのクローラーが高頻度で訪問するため、新しいコンテンツが速くインデックスされる。 更新頻度の低いサイトは、クロール頻度も低くなり、インデックスに時間がかかる。

サイト構造とナビゲーション: 効率的な内部リンク構造を持つサイトは、新しいページが素早く発見されインデックスされやすい。 深い階層構造のサイトは、新しいページの発見とインデックスに時間がかかる場合がある。

サイトマップの提出: 適切に構成されたXMLサイトマップをGoogleサーチコンソールを通じて提出すると、新しいページの発見とインデックスが促進される。

ページの品質とユニーク性: 高品質で独自性のあるコンテンツは、より速くインデックスされる傾向がある。 重複コンテンツや薄いコンテンツは、インデックスが遅れたり、完全に無視されたりする場合がある。

モバイルフレンドリー: モバイル対応のページは、モバイルファーストインデックスの観点から、より速くインデックスされる可能性が高い。

ページ速度: 読み込みが速いページは、クロールとインデックスが効率的に行われる傾向がある。

バックリンクプロファイル: 高品質なバックリンクを持つページは、より速く発見されインデックスされる傾向がある。

robots.txtとメタタグ: robots.txtファイルやnoindexメタタグの不適切な設定が、インデックスを妨げる可能性がある。

サーバーのレスポンス: サーバーのダウンタイムやエラーレスポンスは、クロールとインデックスを遅らせる。

コンテンツの更新頻度: 頻繁に更新されるページは、より頻繁にクロールされインデックスが更新される。

JavaScriptの使用: 重要なコンテンツがJavaScriptによって動的に生成される場合、インデックスに時間がかかる場合がある。

インデックス登録を早めるための戦略:

Googleサーチコンソールの活用: 「URL検査」ツールを使用して、特定のURLのインデックス登録をリクエストする。 サイトマップを定期的に更新し提出する。

内部リンク構造の最適化: 新しいページへの内部リンクを適切に設置し、クローラーの発見を促進する。

ソーシャルメディアの活用: 新しいコンテンツをソーシャルメディアで共有し、クローラーの注目を集める。

高品質コンテンツの継続的な発行: 定期的に価値のあるコンテンツを公開し、クロール頻度を高める。

モバイル対応とページ速度の最適化: モバイルフレンドリーなデザインを採用し、ページ読み込み速度を改善する。

技術的SEOの最適化: robots.txt、HTTPステータスコード、meta robots タグなどを適切に設定する。

インデックス登録から検索結果への反映までの過程:

クロール: Googleのボットがウェブページを発見し、コンテンツを読み取る。

インデックス作成: クロールしたコンテンツが分析され、Googleのインデックスに追加される。

ランキング: インデックスされたページが、各種の検索クエリに対してランク付けされる。

検索結果への表示: ユーザーの検索クエリに応じて、ランク付けされたページが検索結果に表示される。

この過程全体にかかる時間は、前述の要因によって大きく変動します。高品質なコンテンツを持つ、十分に最適化されたウェブサイトであれば、新しいページが数時間から数日で検索結果に反映される可能性があります。一方、新規サイトや最適化が不十分なサイトでは、数週間から数ヶ月かかる場合もあります。

継続的なモニタリングと最適化が重要であり、Googleサーチコンソールを定期的にチェックして、インデックスの状況を把握し、必要に応じて対策を講じることが推奨されます。

Googleにインデックス登録させる基本・ベストプラクティス

Googleにウェブページを効果的にインデックス登録させるためには、様々な基本的なプラクティスとベストプラクティスがあります。これらを適切に実施することで、クロールの効率を高め、インデックス登録の可能性を最大化し、結果として検索結果での可視性を向上させることができます

XMLサイトマップを作成・送信する

XMLサイトマップは、サイト内の重要なページをGoogleに効率的に伝えるための強力なツールです。

ベストプラクティス:

網羅性: インデックスしたい全てのページをサイトマップに含める。 重要度の低いページ(プライバシーポリシーなど)は除外してもよい。

構造化: ページの階層構造を反映したサイトマップを作成する。 大規模サイトの場合、複数のサイトマップを作成し、サイトマップインデックスを使用する。

最適化: 各URLに最終更新日、変更頻度、優先度を適切に設定する。 サイトマップのサイズは50MBまたは50,000URL以下に抑える。

定期的な更新: サイトの変更を反映して、サイトマップを定期的に更新する。 動的生成のサイトマップを検討する。

送信方法: Googleサーチコンソールを通じてサイトマップを送信する。 robots.txtファイルにサイトマップの場所を記載する。

実装例:

xmlCopy

https://www.example.com/

2023-08-26

daily

1.0

XMLサイトマップを適切に作成・送信することで、Googleのクローラーがサイト内の重要なページを効率的に発見し、インデックス登録の優先順位を理解するのに役立ちます。

内部リンクを設置する

効果的な内部リンク戦略は、サイト内のページ間のつながりを強化し、クローラーの動きを最適化するとともに、ユーザーエクスペリエンスを向上させます。

ベストプラクティス:

階層構造の明確化: メインナビゲーションを通じて、サイトの主要カテゴリーを明確に示す。 パンくずリストを実装し、ユーザーとクローラーの位置理解を助ける。

コンテキスト関連リンク: 記事本文内で関連性の高い他のページへのリンクを自然に組み込む。 「関連記事」セクションを設け、類似コンテンツへのリンクを提供する。

アンカーテキストの最適化: リンク先の内容を適切に示す具体的なアンカーテキストを使用する。 「こちら」「詳細」などの一般的な言葉は避ける。

フッターリンクの活用: サイト全体で一貫したフッターナビゲーションを実装し、重要ページへのリンクを含める。

サイロ構造の構築: トピックごとにコンテンツをグループ化し、関連ページ間で相互リンクを行う。

新しいコンテンツの統合: 新規ページを公開する際、既存の関連ページから適切にリンクする。

リンクの深さの管理: 全てのページがホームページから3クリック以内でアクセス可能になるよう設計する。

HTMLサイトマップの作成: ユーザーとクローラー向けに、全体の構造が分かるHTMLサイトマップページを作成する。

実装例:

htmlCopy

適切な内部リンク戦略を実装することで、サイト内の重要なページへのPageRankの流れを最適化し、クローラーのページ発見とインデックス登録を促進します。同時に、ユーザーの回遊性を高め、サイトの滞在時間やページビュー数の増加にも貢献します。

SNS運用を行う

ソーシャルメディアの活用は、直接的なインデックス登録への影響は限定的ですが、間接的にサイトの可視性とクロール頻度を向上させる効果があります。

ベストプラクティス:

定期的な投稿: 新しいコンテンツや更新情報を定期的にSNSで共有する。 投稿頻度と質のバランスを保つ。

プラットフォームの選択: ターゲットオーディエンスに適したSNSプラットフォームを選択する。 各プラットフォームの特性に合わせたコンテンツ戦略を立てる。

エンゲージメントの促進: フォロワーとの対話を積極的に行い、エンゲージメントを高める。 ユーザー生成コンテンツ(UGC)を活用し、コミュニティ感を醸成する。

ハッシュタグの適切な使用: 関連性の高いハッシュタグを使用し、コンテンツの発見可能性を高める。 ブランド固有のハッシュタグを作成し、一貫して使用する。

リッチメディアの活用: 画像や動画を効果的に使用し、投稿の注目度を高める。 アルト

テキストや説明文を適切に設定し、アクセシビリティを確保する。

リンク共有の最適化: シェアされる際のOGPタグを適切に設定し、リッチスニペットを表示させる。 短縮URLではなく、可能な限り元のURLを使用する。

インフルエンサー連携: 業界のインフルエンサーとの関係構築を行い、リーチを拡大する。 ゲスト投稿や共同キャンペーンなどのコラボレーションを検討する。

分析と最適化: SNS運用の効果を定期的に分析し、戦略を継続的に最適化する。 クリック数、エンゲージメント率、コンバージョンなどの指標を追跡する。

実装例(Twitter用のメタタグ):

htmlCopy

SNS運用を効果的に行うことで、サイトへのトラフィックを増加させ、ブランド認知度を高めることができます。これにより、自然なバックリンクの獲得やソーシャルシグナルの向上につながり、間接的にSEOとインデックス登録に好影響を与える可能性があります。

Googleサーチコンソール「URL検査ツール」で、インデックス登録リクエストを行う

Googleサーチコンソールの「URL検査ツール」は、特定のURLのインデックス状況を確認し、必要に応じてインデックス登録をリクエストできる強力な機能です。

ベストプラクティス:

優先順位付け: 最も重要で新しいページから順に検査とリクエストを行う。 すべてのページに対して一律に使用するのではなく、戦略的に活用する。

エラーの修正: 検査結果でエラーが表示された場合、まずそれを修正してから再リクエストする。 モバイルフレンドリー、ページ速度、構造化データなどの問題にも対応する。

クロール頻度の考慮: 頻繁なリクエストはクロール予算を消費するため、本当に必要な場合にのみ使用する。 サイトの更新頻度に応じて適切なタイミングでリクエストを行う。

インデックス除外の確認: noindexタグやrobots.txtによる除外がないか確認する。 意図的に除外しているページには使用しない。

ライブテストの活用: 「ライブテスト」機能を使用して、最新の状態をGoogleに確認してもらう。 変更後のページが正しく表示されているか確認する。

サイトマップとの連携: URL検査ツールの使用と並行して、最新のサイトマップを提出する。 サイトマップ内のURLの優先度設定を適切に行う。

モバイル版の確認: モバイルファーストインデックスに対応するため、モバイル版URLの検査も忘れずに行う。

定期的なフォローアップ: リクエスト後、インデックス状況を定期的に確認する。 長期間インデックスされない場合は、ページの品質や技術的問題を再確認する。

使用手順:

Googleサーチコンソールにログインし、対象のプロパティを選択。

左側のメニューから「URL検査」を選択。

検査したいURLを入力フィールドに貼り付け、「検査」をクリック。

結果を確認し、必要に応じて「インデックス登録をリクエスト」ボタンをクリック。

注意点:

リクエストの濫用は避ける(1日に数十回程度が目安)。

すべてのリクエストが即時に処理されるわけではない。

インデックス登録のリクエストは、Googleがそのページをインデックスする保証ではない。

URL検査ツールを適切に活用することで、重要なページのインデックス登録を促進し、サイトの検索可視性を向上させることができます。ただし、この機能に過度に依存せず、全体的なSEO戦略の一部として位置づけることが重要です。

これらの基本的なベストプラクティスを総合的に実施することで、Googleによるサイトのクロールとインデックス登録を最適化し、検索結果での表示機会を増やすことができます。ただし、SEOは継続的なプロセスであり、常に最新のGoogleのガイドラインや業界のベストプラクティスに注意を払い、適宜戦略を調整していくことが重要です。

Googleサーチコンソールの「ページがインデックスに登録されなかった理由」の各エラー解説

Googleサーチコンソールは、ウェブサイトのインデックス状況を詳細に把握するための重要なツールです。「ページがインデックスに登録されなかった理由」セクションでは、インデックス登録に失敗したページとその理由が表示されます。ここでは、主要なエラーとその解決策について詳しく解説します。

クロール済み - インデックス未登録

このステータスは、Googleがページをクロールしたものの、何らかの理由でインデックスに追加しなかったことを示します。

主な原因:

コンテンツの品質が低い

重複コンテンツ

薄いコンテンツ(情報量が少ない)

ユーザー体験が悪い(低速なページロード、過剰な広告など)

解決策:

コンテンツの品質向上: オリジナルで価値のある情報を提供する。 十分な情報量と深度を持たせる。 ユーザーのニーズに合致したコンテンツを作成する。

重複コンテンツの解消: canonicalタグを適切に設定する。 類似ページを統合または差別化する。

ユーザー体験の改善: ページ速度を最適化する。 モバイルフレンドリーなデザインを採用する。 広告の配置と量を適切に調整する。

内部リンクの最適化: 重要なページへの内部リンクを増やし、ページの重要性を示す。

検出 - インデックス未登録

Googleがページの存在を認識しているものの、まだクロールしていない状態を示します。

主な原因:

クロール予算の制限

サイト構造の複雑さ

サーバーの応答速度が遅い

解決策:

サイト構造の最適化: フラットな階層構造を目指す。 内部リンクを適切に設置し、重要なページへのパスを明確にする。

サイトマップの最適化: 最新で正確なXMLサイトマップを提出する。 重要なページの優先度を適切に設定する。

サーバーパフォーマンスの向上: ホスティングの品質を確認し、必要に応じてアップグレードする。 キャッシュ戦略を実装する。

クロール頻度の最適化: Googleサーチコンソールでクロール頻度設定を確認し、必要に応じて調整を要請する。

noindex タグによって除外されました

ページにnoindexタグが設定されており、意図的にインデックスから除外されていることを示します。

主な原因:

開発中や一時的なページに誤ってnoindexを設定したまま

プラグインやCMSの設定ミス

意図的な除外設定の忘れ

解決策:

noindexタグの確認と削除:

タグを探し、必要に応じて削除する。 HTTPレスポンスヘッダーのX-Robots-Tag: noindexを確認し、必要に応じて削除する。robots.txtファイルの確認: robots.txtファイルでDisallowディレクティブが不適切に設定されていないか確認する。

CMSやプラグインの設定確認: WordPressなどのCMSで「検索エンジンがサイトをインデックスしないようにする」オプションがオンになっていないか確認する。

インデックス登録のリクエスト: noindexタグを削除後、Googleサーチコンソールの「URL検査」ツールを使用してインデックス登録をリクエストする。

重複しています。Google により、ユーザーがマークしたページとは異なるページが正規ページとして選択されました

このエラーは、Googleが同じまたは非常に類似したコンテンツを持つ複数のURLを検出し、ユーザーが指定したものとは異なるURLを正規(カノニカル)として選択したことを示します。

主な原因:

重複コンテンツの存在(WWWとnon-WWW、HTTPとHTTPSなど)

パラメータ付きURLによる重複

プリントページや携帯版ページによる重複

不適切なカノニカルタグの設定

解決策:

カノニカルタグの適切な設定: 重複ページに

を設定する。 HTTPヘッダーでのカノニカル指定も検討する。リダイレクトの適切な設定: WWWとnon-WWW、HTTPとHTTPSの間で301リダイレクトを設定する。

パラメータ管理: Googleサーチコンソールの「URL パラメータ」ツールを使用して、不要なパラメータを管理する。

サイトマップの最適化: XMLサイトマップに正規URLのみを含める。

内部リンクの一貫性: サイト内のリンクで一貫して正規URLを使用する。

コンテンツの差別化: 類似ページがある場合、それぞれのコンテンツを十分に差別化する。

サーバーエラー(5xx)

5xxエラーは、サーバー側の問題によりGoogleがページにアクセスできなかったことを示します。

主な原因:

サーバーの過負荷

サーバーの設定ミス

アプリケーションのエラー

データベース接続の問題

解決策:

サーバーログの分析: エラーの具体的な原因を特定するため、詳細なサーバーログを確認する。

サーバーリソースの最適化: CPU、メモリ、ディスク容量などのリソースが十分かチェックし、必要に応じてアップグレードする。

アプリケーションの最適化: データベースクエリの最適化 キャッシュの適切な利用 コードの効率化

負荷分散の導入: トラフィックが多い場合、負荷分散システムの導入を検討する。

CDNの利用: コンテンツデリバリーネットワーク(CDN)を活用し、サーバーの負荷を分散する。

定期的なモニタリング: サーバーの健全性を継続的に監視し、問題を早期に発見・対処する。

エラーページの適切な設定: 一時的な問題の場合、適切な503エラーページを表示し、リトライのタイミングをGoogleに示唆する。

アクセス禁止(403)が原因でブロックされました

403エラーは、サーバーがリクエストを理解したものの、アクセスを拒否したことを示します。

主な原因:

ファイルやディレクトリのパーミッション設定の誤り

.htaccessファイルの不適切な設定

IPアドレスベースのアクセス制限

ファイアウォールの誤設定

解決策:

ファイルパーミッションの確認: ウェブサーバーが適切な読み取り権限を持っているか確認する。 通常、ファイルは644、ディレクトリは755のパーミッションが推奨される。

.htaccessファイルの見直し: 不要なアクセス制限がないか確認する。 Googlebotの User-Agent が誤ってブロックされていないか確認する。

IPアドレス制限の確認: Googleボットの IPアドレス範囲が誤ってブロックされていないか確認する。 必要に応じて、Googleボットの IPアドレスを許可リストに追加する。

ファイアウォール設定の確認: ウェブアプリケーションファイアウォール(WAF)の設定を確認し、誤ってGooglebotをブロックしていないか確認する。

robots.txtの確認: robots.txtファイルで意図せずにページへのアクセスを禁止していないか確認する。

Googleサーチコンソールでの確認: 「セキュリティとマニュアルによる対応」セクションで、サイトに対するマニュアルペナルティがないか確認する。

robots.txt によりブロックされました

このエラーは、robots.txtファイルの設定によってGooglebotがページにアクセスできないことを示します。

主な原因:

robots.txtファイルの不適切な設定

開発環境の設定が本番環境に残っている

セキュリティ上の過剰な制限

解決策:

robots.txtファイルの見直し: 重要なページや公開ページがDisallowディレクティブでブロックされていないか確認する。 必要に応じて、Allowディレクティブを使用して特定のページへのアクセスを許可する。

Googleボット専用の設定: Copy

User-agent: Googlebot Allow: /important-directory/のように、Googlebotに対して特定のディレクトリへのアクセスを許可する。ワイルドカードの適切な使用:

Disallow: /*のような過度に広範囲なブロックを避ける。 必要に応じて、より具体的なパスを指定する。サイトマップの指定: robots.txtファイル内でサイトマップのURLを指定し、重要なページの存在をGoogleに示唆する。

Googleサーチコンソールの活用: 「robots.txtテスター」ツールを使用して、設定の影響を事前に確認する。

段階的なアクセス許可: 全ページを一度に公開するのではなく、重要なページから段階的にアクセスを許可する。

定期的な見直し: サイトの構造変更や新しいセクションの追加時には、robots.txtの設定を再確認する。

これらのエラーに適切に対処することで、Googleによるサイトのクロールとインデックス登録を最適化し、検索結果での表示機会を増やすことができます。ただし、各エラーの解決には技術的な知識が必要な場合があるため、必要に応じてウェブ開発者やSEO専門家に相談することをお勧めします。

また、これらの問題に対処する際は、以下の点に注意することが重要です:

変更の影響を慎重に検討する: 特に大規模なサイトでは、robots.txtやnoindexタグの変更が予期せぬ結果を招く可能性があります。変更前に十分なテストと検証を行いましょう。

段階的なアプローチ: すべての問題を一度に解決しようとするのではなく、最も重要なページや問題から順に対処していくことをお勧めします。

モニタリングの重要性: 変更後は、Googleサーチコンソールを通じて継続的にインデックス状況をモニタリングし、必要に応じて追加の調整を行います。

ユーザーエクスペリエンスの考慮: 技術的な最適化だけでなく、常にユーザーにとっての価値を念頭に置いて改善を行うことが重要です。

Googleのガイドラインの遵守: すべての最適化は、Googleのウェブマスターガイドラインに準拠している必要があります。違反行為は、かえってペナルティの原因となる可能性があります。

インデックス登録の問題に適切に対処することで、サイトの検索エンジンでの可視性が向上し、オーガニックトラフィックの増加につながります。継続的な監視と最適化を行うことで、長期的なSEO成功を実現できるでしょう。

インデックスに登録されていないページ数の確認方法

Googleサーチコンソールを使用して、インデックスに登録されていないページ数を確認し、その理由を理解することは、効果的なSEO戦略を立てる上で非常に重要です。以下に、詳細な確認方法と解釈のガイドラインを示します。

Googleサーチコンソールにアクセス: https://search.google.com/search-console にアクセスし、対象のプロパティを選択します。

「インデックス」→「カバレッジ」を選択: 左側のメニューから「インデックス」を選択し、さらに「カバレッジ」をクリックします。

「有効」タブと「エラー」タブの確認: 「有効」タブ: インデックスに正常に登録されているページ 「エラー」タブ: インデックスに登録されていないページとその理由

各カテゴリの詳細を確認: エラーの種類ごとに、影響を受けているURLの数が表示されます。 各エラーをクリックすると、具体的なURLリストと詳細な説明が表示されます。

時系列データの分析: グラフを確認し、インデックス登録状況の推移を把握します。 急激な変化がある場合、その時期に行ったサイトの変更や更新との関連性を検討します。

エクスポート機能の活用: 詳細な分析が必要な場合、データをCSVファイルとしてエクスポートできます。

主要なエラーカテゴリとその解釈:

a. サーバーエラー (5xx):

サーバーの安定性や設定に問題がある可能性があります。

ホスティングプロバイダーとの連携が必要な場合があります。

b. 404 (見つかりません):

削除されたページや誤ったリンクが存在する可能性があります。

301リダイレクトの設定や、内部リンクの修正が必要かもしれません。

c. ソフト404エラー:

存在しないページに対して適切な404ステータスコードを返していない可能性があります。

エラーページの設定を見直す必要があります。

d. アクセス禁止 (403):

サーバーの権限設定やファイアウォールの問題の可能性があります。

.htaccessファイルやサーバー設定の確認が必要です。

e. リダイレクトエラー:

リダイレクトの連鎖や循環が発生している可能性があります。

リダイレクト設定の最適化が必要です。

f. クローラーのアクセスがブロックされています:

robots.txtファイルの設定を確認し、必要に応じて修正します。

g. 送信済み URL が見つかりません:

サイトマップに含まれているが実際には存在しないページがある可能性があります。

サイトマップの更新や、動的生成の場合はその設定の確認が必要です。

インデックスに登録されていないページ数を減らすための一般的なアプローチ:

優先順位付け: 最も重要なページや、ビジネスにとって価値の高いページから対処します。

テクニカルSEOの最適化: サイト速度、モバイルフレンドリー性、HTTPS対応など、基本的な技術要素を最適化します。

コンテンツの品質向上: 薄いコンテンツや重複コンテンツを特定し、改善または統合します。

内部リンク構造の最適化: 重要なページへの内部リンクを増やし、サイト構造を改善します。

サイトマップの最適化: 最新かつ正確なXMLサイトマップを定期的に提出します。

定期的なコンテンツ監査: 古いコンテンツをいつ更新するか、削除するか、またはリダイレクトするかを定期的に評価します。

モバイル対応の強化: モバイルファーストインデックスに対応するため、モバイル版サイトの最適化に注力します。

ユーザーエクスペリエンスの改善: ページの読み込み速度、ナビゲーションの使いやすさ、コンテンツの読みやすさを向上させます。

インデックスに登録されていないページ数を継続的にモニタリングし、適切に対処することで、サイト全体のSEOパフォーマンスを向上させることができます。ただし、すべてのページをインデックスに登録する必要はなく、品質の低いページや重要でないページは意図的にインデックスから除外することも検討すべきです。重要なのは、ビジネス目標に沿って戦略的にアプローチすることです。

Googleにインデックス登録されているのに表示されないケース

Googleにインデックス登録されているにもかかわらず、検索結果に表示されないケースがあります。これは多くのウェブサイト所有者や管理者が直面する問題の一つです。以下に、主な原因と対策について詳しく説明します。

競争の激しいキーワード

原因:

対象のキーワードに関して、多くの高品質なコンテンツが存在する。

自社サイトの権威性や関連性が競合他社に比べて低い。

対策:

a. ロングテールキーワードの活用:

より具体的で競争の少ないキーワードを狙う。

例: 「靴」→「東京都内の幅広甲高靴専門店」

b. コンテンツの質と量の向上:

より詳細で価値のある情報を提供する。

定期的に新しいコンテンツを追加する。

c. バックリンクプロファイルの改善:

高品質な外部サイトからのリンクを獲得する。

業界関連のディレクトリやリソースページへの掲載を目指す。

d. ユーザーエンゲージメントの向上:

CTR(クリック率)を高めるためのメタディスクリプションの最適化。

サイト内での滞在時間を増やすためのUX改善。

低品質または薄いコンテンツ

原因:

コンテンツが短すぎる、または情報量が少ない。

ユーザーのクエリに十分に答えていない。

対策:

a. コンテンツの拡充:

既存のコンテンツを詳細化し、情報量を増やす。

関連する追加情報、例、事例研究などを含める。

b. ユーザーインテントの理解:

検索クエリの背後にあるユーザーの意図を分析する。

インテントに合致した包括的な情報を提供する。

c. マルチメディアの活用:

画像、動画、インフォグラフィックなどを適切に使用する。

視覚的な情報でコンテンツを補強する。

d. 定期的な更新:

コンテンツを定期的に見直し、最新の情報を反映させる。

「最終更新日」を明示し、鮮度を示す。

技術的なSEO問題

原因:

ページ速度が遅い。

モバイルフレンドリーでない。

HTTPS化されていない。

構造化データが適切に実装されていない。

対策:

a. ページ速度の最適化:

画像の圧縮と最適化。

JavaScriptとCSSの最小化。

ブラウザキャッシュの活用。

CDN(コンテンツデリバリーネットワーク)の利用。

b. モバイル対応の強化:

レスポンシブデザインの採用。

AMPの実装検討。

モバイルでの使いやすさ向上(タップターゲットのサイズ調整など)。

c. HTTPS化:

SSL証明書の導入。

全ページのHTTPSへの移行と適切なリダイレクト設定。

d. 構造化データの最適化:

Schema.orgマークアップの適切な実装。

Googleサーチコンソールの「リッチリザルト」レポートでの確認と修正。

ペナルティや手動対応

原因:

Googleのガイドライン違反(スパム行為、過剰なリンク構築など)。

ユーザー体験を損なう要素(過剰な広告、誤解を招くコンテンツなど)。

対策:

a. Googleサーチコンソールの確認:

「セキュリティとマニュアルによる対応」セクションでペナルティの有無を確認。

b. ガイドライン違反の修正:

スパム的なリンクの削除やディスアバウ。

過剰な最適化の修正(キーワードの詰め込みなど)。

c. リカバリーリクエストの提出:

問題を修正後、Googleにリカバリーリクエストを提出。

d. ユーザー体験の改善:

広告の適切な配置と数の調整。

クリックベイト的なタイトルや誤解を招く内容の修正。

インデックスの鮮度の問題

原因:

古いバージョンのページがキャッシュされている。

頻繁な更新がGoogleに認識されていない。

対策:

a. URL検査ツールの活用:

Googleサーチコンソールの「URL検査」ツールで最新のクロール状況を確認。

必要に応じてインデックス登録をリクエスト。

b. XML サイトマップの最適化:

最終更新日を正確に反映したサイトマップの定期的な提出。

c. 内部リンク構造の改善:

新しいコンテンツへの内部リンクを増やし、クロールの頻度を高める。

d. 動的生成コンテンツの対応:

JavaScriptで動的に生成されるコンテンツの適切なレンダリング確認。

検索意図とのミスマッチ

原因:

コンテンツが検索クエリの意図と合致していない。

タイトルやメタディスクリプションが適切でない。

対策:

a. 検索意図の分析:

対象キーワードでトップランクのページを分析し、ユーザーの求める情報を理解する。

b. コンテンツの最適化:

検索意図に合わせてコンテンツを再構成または追加。

情報型、ナビゲーション型、トランザクション型など、意図のタイプに応じた対応。

c. タイトルとメタディスクリプションの改善:

検索意図を反映したキーワードの適切な使用。

ユーザーの興味を引く魅力的な記述。

d. ニーズの包括的な対応:

関連する疑問や問題に対する回答を含める。

FAQセクションの追加を検討。

インデックスの優先順位の問題

原因:

サイト内に類似コンテンツが多数存在し、Googleが最適なページを選択できていない。

サイトの構造が複雑で、重要なページの優先度が低く認識されている。

対策:

a. カノニカルタグの適切な使用:

重複コンテンツに対して正規URLを明確に指定。

b. 内部リンク構造の最適化:

重要なページへの内部リンクを増やし、ページの重要性を示唆。

c. サイト構造の簡素化:

フラットな階層構造を目指し、重要ページへのクリック数を最小限に。

d. コンテンツの統合または差別化:

類似コンテンツの統合や、明確な差別化を行い、ページの一意性を高める。

これらの対策を実施する際は、一つずつ段階的に行い、その効果を測定しながら進めることが重要です。また、変更後はGoogleサーチコンソールを通じて継続的にモニタリングを行い、インデックス状況や検索パフォーマンスの変化を注視してください。

本記事の内容には万全を期しておりますが、情報の正確性や完全性を保証するものではありません。万が一、誤りや不適切な表現等を発見された場合は、以下の方法でご連絡いただけますと幸いです。

SEO・LLMOコラム一覧へ戻る

メディアリーチのホワイトペーパー・資料ダウンロード

LLMO(AI検索対策) 業種別対策ガイド 2026年版

今すぐ資料ダウンロード

【資料】AI Overviews 徹底解説 2025年版 資料

今すぐ資料ダウンロード

LLMOの教科書 2026年最新版 - 資料ダウンロード

今すぐ資料ダウンロード

メディアリーチの最新イベント・ウェビナー情報

オンライン

2026年3月4日(水)14:00〜15:00

【終了】【3/4】AI検索時代の検索マーケティング 2026|SEOとAI検索対策(LLMO)戦略解...

オンライン

2026年1月28日(水)14:00〜15:00

【アーカイブ動画】【1/28】LLMO(AI検索最適化)ブランド推薦の戦略・最新トレンド徹底解説 セ...

オンライン

2026年1月21日(水)13:00〜14:00

【アーカイブ動画】【1/21】AI時代のSEO戦略 〜 EEAT徹底解説ウェビナー2026 〜